Cache costuma entrar na conversa sempre que alguém fala em performance. A ideia é simples: “se está lento, coloca cache”. O problema é que, na prática, cache mal aplicado resolve um problema e cria outros.

Não é raro ver sistemas que até funcionam bem sem cache, mas ficam difíceis de manter depois que ele entra sem critério.

Cache não é ponto de partida

Antes de pensar em cache, vale responder uma pergunta básica:

onde o sistema está lento?

Muitas vezes o problema não é falta de cache, mas:

- query mal escrita;

- lógica duplicada;

- processamento desnecessário;

- excesso de chamadas externas.

Colocar cache sem entender o gargalo real só esconde o problema por um tempo.

Quando cache realmente faz sentido

Cache funciona bem quando você tem:

- dados lidos muitas vezes;

- dados que mudam pouco;

- custo alto de processamento ou consulta.

Configurações, listas estáticas, resultados agregados e respostas de APIs externas são bons candidatos. Nesse cenário, o cache reduz carga e melhora tempo de resposta de forma consistente.

O problema começa na invalidação

Cache quase nunca dá problema na criação. Ele dá problema na invalidação.

Quando não fica claro:

- quando o cache expira;

- quem invalida;

- o que acontece se falhar;

o sistema começa a servir dado errado. E dado errado em produção costuma ser pior que erro explícito.

Cache que vira dependência

Um sinal claro de problema é quando o sistema depende do cache para funcionar corretamente.

Se desligar o cache quebra tudo, isso indica que:

- a lógica base não está saudável;

- o cache está mascarando problemas estruturais;

- o código ficou acoplado demais a essa camada.

Cache deveria acelerar, não sustentar o sistema.

Cuidado com cache em dados muito voláteis

Cache em dados que mudam o tempo todo geralmente gera:

- inconsistência;

- comportamento estranho;

- bugs intermitentes.

Quanto mais volátil o dado, maior o custo mental e técnico para manter o cache correto. Em muitos casos, o ganho de performance não compensa a complexidade introduzida.

Cache também tem custo

Cache não é gratuito.

Ele consome memória, adiciona mais uma camada ao sistema e aumenta a complexidade de debug. Quando algo dá errado, você precisa verificar:

- código;

- banco;

- cache;

- estratégia de expiração.

Cada camada extra aumenta o esforço para entender o que está acontecendo.

Uma regra simples que ajuda

Uma regra prática que costuma funcionar bem:

Primeiro, faça o sistema funcionar corretamente sem cache.

Depois, use cache para otimizar pontos específicos e bem entendidos.

Isso evita decisões precipitadas e mantém o sistema mais previsível.

Bancos de cache, CDN e cache em borda: onde cada um faz sentido

Quando se fala em cache, muita gente mistura tudo como se fosse a mesma coisa. Na prática, existem camadas diferentes de cache, cada uma com um papel específico. Entender isso evita decisões erradas e expectativas irreais.

Cache em memória (Redis, Memcached)

Bancos de cache em memória, como Redis, são muito usados no backend porque são rápidos e flexíveis. Eles fazem sentido quando você precisa:

- reduzir acesso ao banco de dados;

- compartilhar cache entre múltiplos processos;

- armazenar dados temporários com expiração controlada;

- lidar com alta concorrência.

Redis funciona muito bem para:

- resultados de queries pesadas;

- locks e controle de concorrência;

- sessões;

- dados derivados de outras fontes.

O erro comum aqui é transformar o Redis em “banco principal”. Cache não é fonte de verdade. Se os dados do Redis forem perdidos, o sistema precisa continuar funcionando.

Cache de aplicação ≠ cache de infraestrutura

Cache dentro da aplicação resolve problemas diferentes de cache na borda.

Cache de aplicação (Redis, cache local, etc):

- reduz custo de processamento;

- protege banco e serviços internos;

- atua no backend.

Já cache de infraestrutura atua antes da requisição chegar no servidor.

CDN e cache em borda

CDN (Content Delivery Network) e cache em borda são ideais para:

- conteúdo estático;

- respostas públicas;

- páginas que não mudam com frequência.

Nesse cenário, o cache:

- reduz latência;

- diminui carga no servidor;

- melhora experiência do usuário.

Cloudflare, por exemplo, atua nesse nível, servindo conteúdo direto da borda sem que a requisição chegue no backend.

Cloudflare não substitui cache de backend

Um erro comum é achar que, usando Cloudflare ou outra CDN, não é mais necessário cache no backend. Isso não é verdade.

Cloudflare:

- ajuda muito com páginas públicas;

- protege contra picos de acesso;

- reduz tráfego direto no servidor.

Mas ele não resolve:

- lógica pesada no backend;

- chamadas internas;

- processamento de regras de negócio;

- APIs autenticadas.

As camadas se complementam, não se substituem.

Combinar camadas de cache com consciência

Em sistemas mais maduros, é comum ter:

- cache em Redis no backend;

- cache HTTP para respostas públicas;

- CDN para conteúdo estático;

- regras claras de expiração e invalidação.

O ponto crítico é não perder controle. Quanto mais camadas, maior a necessidade de saber:

- onde o dado está sendo cacheado;

- por quanto tempo;

- quem invalida.

Sem isso, debug vira loteria.

Cache certo no lugar certo

Não existe “o melhor cache”. Existe cache adequado ao problema.

Usar Redis para tudo, Cloudflare para tudo ou cachear tudo geralmente leva a soluções frágeis. Cada camada resolve um tipo de problema específico, e ignorar isso gera sistemas difíceis de operar.

Um exemplo prático de cache bem aplicado em alto volume

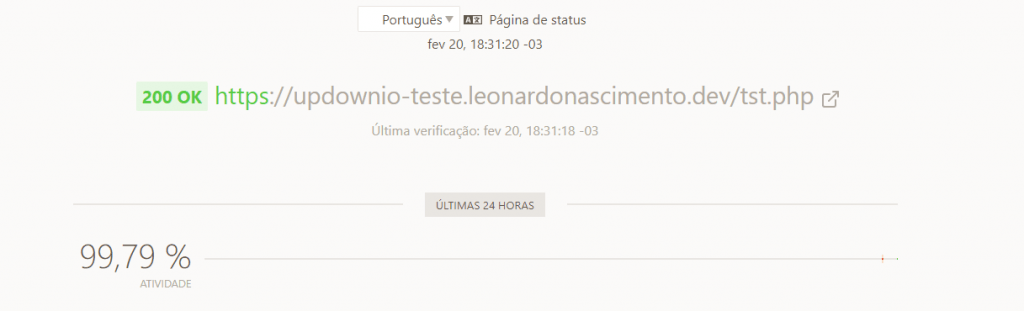

Em um projeto onde trabalhei, o sistema recebia mais de 30 milhões de visualizações por mês. O volume era alto, os picos eram imprevisíveis e qualquer erro de arquitetura aparecia rápido.

A solução não foi um único tipo de cache, mas a combinação correta de camadas, cada uma resolvendo um problema específico.

Cache no backend

No backend, utilizávamos cache em memória para reduzir acesso ao banco e evitar processamento repetido. Consultas mais pesadas e dados derivados eram armazenados com tempo de vida bem definido.

Esse cache não era tratado como fonte de verdade. Se fosse limpo ou reiniciado, o sistema continuava funcionando normalmente, apenas com impacto temporário de performance.

Cache no servidor web

No nível do servidor web, respostas públicas eram cacheadas diretamente, evitando que requisições idênticas chegassem até a aplicação.

Isso reduzia drasticamente:

- consumo de CPU;

- execução de código desnecessário;

- abertura de conexões com o backend.

Para grande parte do tráfego, a aplicação nem chegava a ser executada.

Cache em servidor de borda

Além disso, havia cache em servidores distribuídos geograficamente, entregando conteúdo diretamente próximo ao usuário final.

Essa camada absorvia picos de acesso e reduzia latência, principalmente em horários de maior tráfego. Em muitos casos, a requisição nem chegava ao servidor de origem.

O ponto mais importante: controle

O que fez essa estratégia funcionar não foi o volume de cache, mas o controle sobre ele.

Cada camada tinha:

- regras claras de expiração;

- critérios bem definidos de cache e bypass;

- invalidação consciente quando o conteúdo mudava.

Nada era “cacheado por padrão”.

O resultado prático

Com essa abordagem:

- o sistema se manteve estável mesmo em picos;

- o backend ficou protegido;

- o banco deixou de ser gargalo;

- a operação ficou previsível.

Cache não foi usado como remendo, mas como parte da arquitetura.

Lição aprendida

Cache funciona quando é pensado como estratégia, não como solução emergencial. Em sistemas de alto volume, separar responsabilidades entre backend, servidor web e borda faz toda a diferença.

Conclusão

Cache é uma ferramenta poderosa, mas perigosa quando usada sem critério. Ele melhora performance quando aplicado com consciência, e cria problemas quando entra apenas como “solução rápida”.

Entender quando não usar cache é tão importante quanto saber usá-lo.